👋 Olá! Este conteúdo é exclusivo para colaboradores.

Faça Login para acessar esta página e aproveitar todos os recursos disponíveis.

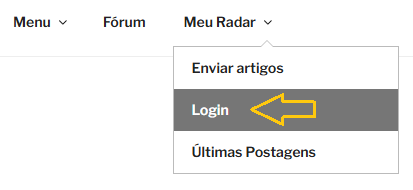

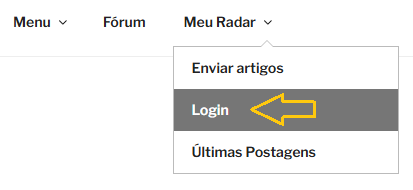

Selecione no Menu acima a opção: Meu Radar e escolha Login.

Precisa de ajuda? Fale com a GANM/DEINM.

Faça Login para acessar esta página e aproveitar todos os recursos disponíveis.

Selecione no Menu acima a opção: Meu Radar e escolha Login.

Precisa de ajuda? Fale com a GANM/DEINM.